Modèle de mélanges gaussiens - Définition

La liste des auteurs de cet article est disponible ici.

Introduction

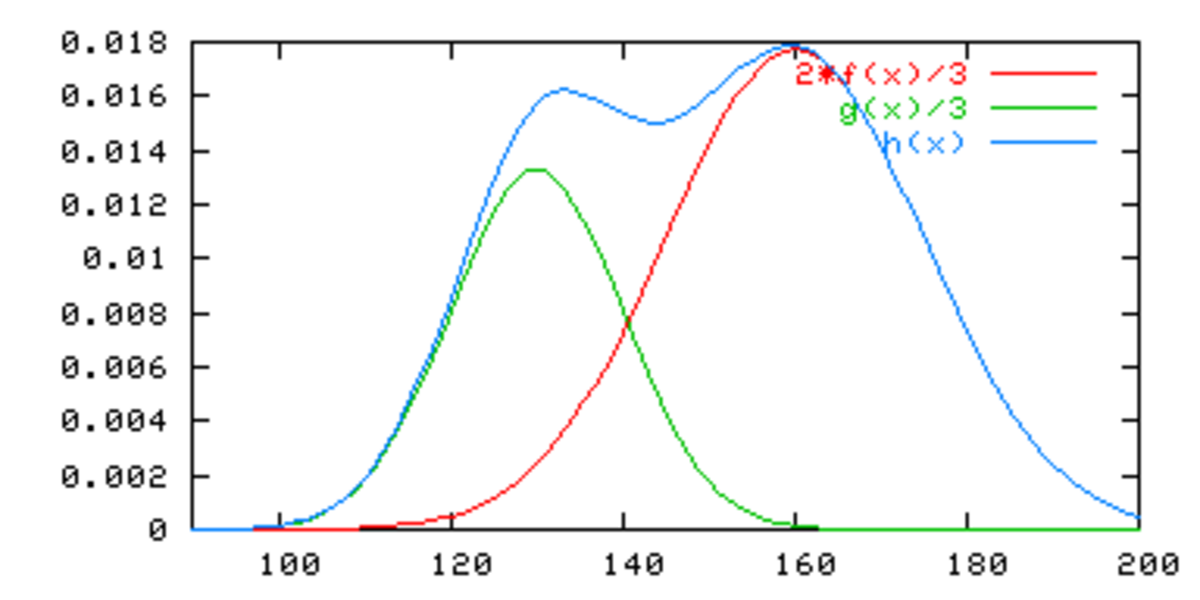

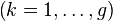

Un modèle de mélange gaussien (usuellement abrégé par l'acronyme anglais GMM pour Gaussian Mixture Model) est un modèle statistique exprimé selon une densité mélange. Elle sert usuellement à estimer paramétriquement la distribution de variables aléatoires en les modélisant comme une somme de plusieurs gaussiennes (appelées noyaux). Il s'agir alors de déterminer la variance, la moyenne et l'amplitude de chaque gaussienne. Ces paramètres sont optimisés selon un critère de maximum de vraisemblance pour approcher le plus possible la distribution recherchée. Cette procédure se fait le plus souvent itérativement via l'algorithme espérance-maximisation (EM).

Utilisation en classification automatique

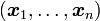

Dans les modèles de mélanges, fréquemment utilisées en classification automatique, on considère qu'un échantillon de données suit, non pas une loi de probabilité usuelle, mais une loi dont la fonction de densité est une densité mélange.

Bien que n'importe quelle loi puisse être utilisée, la plus courante est la loi normale dont la fonction de densité est une gaussienne. On parle alors de mélange gaussien.

Le problème classique de la classification automatique est de considérer qu'un échantillon de données provienne d'un nombre de groupes inconnus a priori qu'il faut retrouver. Si en plus, on considère que les lois que suivent les individus sont normales, alors on se place dans le cadre des modèles de mélanges gaussiens.

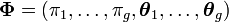

Par la suite, on notera

avec

La principale difficulté de cette approche consiste à déterminer le meilleur paramètre

L'estimation des paramètres peut être effectuée au moyen de l'algorithme EM.

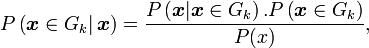

Une fois l'estimation effectuée, il s'agit d'attribuer à chaque individu la classe à laquelle il appartient le plus probablement. Pour cela, on utilise la règle d'inversion de Bayes. D'après celle-ci, on a

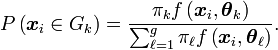

ce qui se traduit, dans notre cas, par

Il suffit alors d'attribuer chaque individu

Modèles parcimonieux

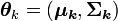

Un problème qu'on peut rencontrer lors de la mise en œuvre des modèles de mélange concerne la taille du vecteur de paramètres à estimer. Dans le cas d'un mélange gaussien de g composantes de dimension p le paramètre est de dimension k(1 + p + p2) − 1. La quantité de données nécessaire à une estimation fiable peut alors être trop importante par rapport au coût de leur recueil.

Une solution couramment employée est de déterminer quelles sont, parmi toutes les variables disponibles, celles qui apporteront le plus d'information à l'analyse et d'éliminer les variables ne présentant que peu d'intérêt. Cette technique, très employée dans des problèmes de discrimination l'est moins dans les problèmes de classification.

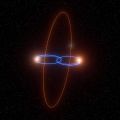

Une méthode alternative consiste à considérer des modèles dits parcimonieux dans lesquels on contraint le modèle initial de manière à n'estimer qu'un nombre plus restreint de paramètres. Dans le cas gaussien, la paramétrisation synthétique des lois de probabilités grâce à deux ensembles

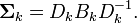

En notant Bk la matrice des valeurs propres de

D'autre part, Bk peut également être décomposée en Bk = λkAk où λk est un réel et Ak une matrice dont le déterminant vaut 1. En utilisant ces notations, on peut considérer que λk représente le volume de la classe, la matrice Ak représente sa forme et Dk son orientation.

Il est alors possible d'ajouter des hypothèses sur formes, des volumes ou les orientations des classes :

- Formes quelconques : En fixant des contraintes d'égalité entre les Ak, les Dk ou les λk, on peut générer 8 modèles différents. On peut par exemple considérer des volumes et des formes identiques mais orientées différemment, ou encore des formes et orientations identiques avec des volumes différents, etc.

- Formes diagonales : En considérant que les matrices Dk sont diagonales, on oblige les classes à être alignées sur les axes. Il s'agit en fait de l'hypothèse d'indépendance conditionnelle dans laquelle les variables sont indépendantes entre elles à l'intérieur d'une même classe.

- Formes sphériques : En fixant Ak = I, on se place dans le cas ou les classes sont de formes sphériques, c’est-à-dire que les variances de toutes les variables sont égales à l'intérieur d'une même classe.