Physique des particules - Définition

La physique des particules est la branche de la physique qui étudie les constituants élémentaires de la matière et les rayonnements, ainsi que leurs interactions. On l'appelle aussi physique des hautes énergies car de nombreuses particules élémentaires n'existent pas à l'état naturel et peuvent seulement être détectées lors de collisions à hautes énergies entre particules plus grandes dans les accélérateurs de particules.

Historique

L'idée que la matière se compose de particules élémentaires date au moins du VIe siècle av. J.-C. La doctrine philosophique de l'atomisme a été étudiée par les philosophes grecs tels que Leucippe, Démocrite, et Épicure. Bien qu'au XVIIe siècle, Isaac Newton pensait que la matière était composée des particules, c'est John Dalton qui, en 1802, énonça formellement que tout est constitué d'atomes minuscules.

En 1869, le premier tableau périodique de Dimitri Mendeleïev permit d'affermir le point de vue prévalent durant tout le XIXe siècle que la matière était faite d'atomes. Les travaux de Joseph John Thomson établirent que les atomes sont composés d'électrons légers et de protons massifs. Ernest Rutherford établit que les protons sont concentrés dans un noyau compact. Initialement, on pensait que le noyau était seulement constitué de protons et d'électrons confinés (afin d'expliquer la différence entre la charge et le nombre de masse), mais ultérieurement il s'avéra qu'il était constitué de protons et de neutrons.

Au XXe siècle, les progrès de la physique nucléaire et de la physique quantique, culminant avec les preuves de la fission nucléaire et fusion nucléaire, donna naissance à une industrie capable de produire un atome à partir d'un autre, rendant même possible (mais non rentable économiquement) la transmutation de plomb en or.

Tout au long des années 1950 et des années 1960, une variété ahurissante de particules a été trouvée lors d'expériences de dispersion. Ceci fut appelé le zoo de particules. Cette expression fut désapprouvée après la formulation du modèle standard dans les années 1970 car le grand nombre de particules put être expliqué comme résultant de combinaisons d'un relativement petit nombre de particules fondamentales.

Les grandes dates de la physique des particules

- 1873 : James Clerk Maxwell réalise d'importantes recherches dans trois domaines : la vision de la couleur, la théorie moléculaire et la théorie électromagnétique. Les idées soulignant les théories de Maxwell sur l'électromagnétisme décrivent la propagation des ondes lumineuses dans le vide.

- 1874 : George Stoney développe la théorie de l'électron et estime sa masse.

- 1895 : Wilhelm Röntgen découvre les rayons X.

- 1896 : Henri Becquerel découvre la radioactivité de l'uranium.

- 1898 : Marie et Pierre Curie séparent les éléments radioactifs. Joseph John Thomson découvre l'électron et crée un modèle où l'atome est décrit comme une entité de charge neutre (contenant un noyau positif avec de petits électrons négatifs).

- 1900 : Max Planck suggère que les rayonnements sont quantifiables (ils ne peuvent prendre que des valeurs qui sont des multiples d'une valeur élémentaire appelée quantum).

- 1905 : Albert Einstein, l'un des rares scientifiques qui considéra sérieusement les idées de Planck, propose un quantum de lumière (le photon) qui se comporte comme une particule. Les autres théories d'Einstein expliquent l'équivalence de la masse et de l'énergie, la dualité onde-particule des photons, le principe d'équivalence et la relativité restreinte.

- 1909 : Hans Geiger et Ernest Marsden, sous la responsabilité d'Ernest Rutherford, envoient des particules alpha sur une feuille d'or et observent de grands angles de diffusion, ce qui suggère l'existence d'un noyau positivement chargé, petit et dense à l'intérieur de l'atome.

- 1911 : Ernest Rutherford conclut à l'existence du noyau comme résultat de l'expérience de diffusion alpha réalisée par Hans Geiger et Ernest Marsden.

- 1913 : Niels Bohr construit la théorie de la structure atomique basée sur des hypothèses quantiques.

- 1919 : Ernest Rutherford prouve l'existence du proton.

- 1921 : James Chadwick et E.S. Bieler concluent qu'une force de grande intensité (dite forte) maintient le noyau uni.

- 1923 : Arthur Compton découvre la nature quantique (particulaire) des rayons X, confirmant que les photons sont des particules.

- 1924 : Louis de Broglie propose des propriétés ondulatoires pour la matière.

- 1925 : Wolfgang Pauli formule le principe d'exclusion pour les électrons à l'intérieur d'un atome. W. Bothe et H. Geiger démontrent que l'énergie et la masse sont conservées dans les processus atomiques.

- 1926 : Erwin Schrödinger développe la mécanique ondulatoire, qui décrit le comportement des systèmes quantiques pour les bosons. Max Born donne une interprétation probabiliste de la mécanique quantique. G.N. Lewis propose le nom de photon pour le quantum de lumière.

- 1927 : Découverte de la désintégration β.

- 1928 : Dirac propose son équation d’onde relativiste pour l’électron.

- 1930 : W. Pauli suggère l’existence du neutrino.

- 1930 : Particules élémentaires incluent: - électron, proton, neutron (dans le noyau), neutrino dans la désintégration β, photon, le quantum de champ électromagnétique.

- 1931 : Découverte du positron e+ (Anderson). Dirac réalise que le positron est aussi décrit par son équation.

- 1932 : Découverte du neutron n (James Chadwick).

- 1933/34 : Théorie de Fermi de la désintégration β (interaction faible): ex. n → p + e− + ¯νe.

- 1935 : Hypothèse de Hideki Yukawa sur les mésons : La force nucléaire est due à l’échange de particules massives, les mésons.

- 1937 : Découverte du lepton μ (muon). Interprété initialement, à tort,comme le méson de Yukawa, le muon s’avère trop “pénétrant”.

- 1938 : Énoncé de la loi de conservation du nombre baryonique.

- 1946/47 : Découverte du méson chargé π±, le pion (Cecil Frank Powell). Le μ est produit par le processus π+ → μ+ + νμ.

- 1946/50 : Théorie quantique de l’électromagnétisme (QED) (Feynman, Schwinger et Tomonaga).

- 1948 : Production artificielle du π+.

- 1949 : Découverte du K+.

- 1950 : Découverte du pion neutre, π0 → γ + γ.

- 1951 : Découverte d'événements en " V " à Brookhaven, New York. Particules K0 et Λ ayant une vie moyenne " étrangement " longue et nouveau nombre quantique “l’étrangeté”.

- 1952 : Découverte du Δ (état excité du nucléon).

- 1954 : Yang et Mills proposent les théories de jauge non-abéliennes.

- 1955 : Découverte de l'antiproton ¯p (Chamberlain et Segrè).

- 1956 : Lee et Yang suggèrent que la force faible peut générer une violation de P (parité).

- 1956 : Découverte de la violation de P dans les atomes de 60Co par Wu et Amber.

- 1960/70 : Découverte de centaines de particules “élémentaires” (ρ, ω, K∗, Δ, Ξ, ....)

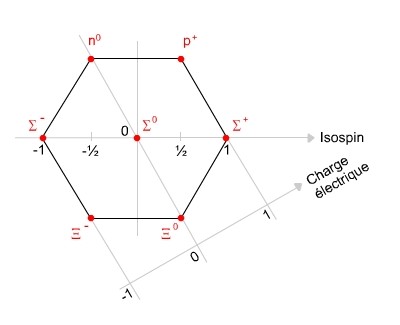

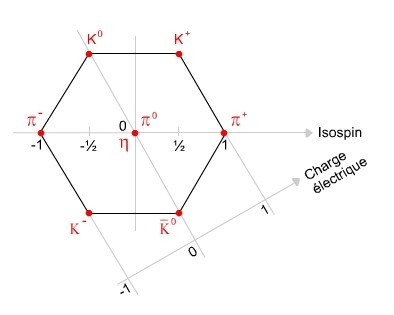

- 1961 : Murray Gell-Mann propose la voie octuple SU(3).

- 1962 : Découverte de νμ et νe.

- 1964 : Existence des quarks u, d, s proposée (Gell-mann and Zweig).

- 1964 : Le quark c est suggéré.

- 1964 : Découverte de la violation de CP dans les systèmes K0 − ¯K0 par Cronin, Fitch, Christianson et Turlay.

- 1965 : Le nombre quantique de la couleur est proposé : toutes les particules observées sont de couleur neutre.

- 1967 : Sheldon Glashow-Salam-Weinberg proposent l’unification des forces électromagnétiques et faibles. Prédiction de l’existence du Higgs.

- 1968-69 : SLAC détecte une structure ponctuelle du nucléon.

- 1973 : QCD : la théorie des interactions fortes entre particules colorées. Prédiction de l’existence des gluons.

- 1973 : Liberté asymptotique postulée.

- 1974 : Découverte du J/ψ et du quark charmé c, à l'université Stanford et Brookhaven, USA.

- 1976 : Découverte d’un troisième lepton chargé, le τ−.

- 1976 : Découverte du D0 et confirmation de l’existence du quark c.

- 1978 : Découverte d’un cinquième quark, le bottom b, à Fermilab, USA.

- 1979 : Découverte d’un gluon à DESY, Hambourg.

- 1983 : Découverte du Z0 et du W± au CERN.

- 1990 : Mesure au LEP (CERN) impliquant que le nombre de neutrinos “légers” (m < 45 GeV) est limité à 3.

- 1995 : Découverte d’un sixième quark, le top t, à Fermilab, USA.

- 1998 : Évidence de neutrinos massifs à Super-Kamiokande, Japon.

Classement des particules subatomiques

Introduction

Les particules élémentaires peuvent être classées en différentes sous catégories en fonction de leur nature.

Leptons, hadrons et quarks

Leptons

Les leptons (ainsi nommés parce que leurs masses étaient relativement petites) sont caractérisés par les propriétés suivantes:

1. Ce sont des particules qui n’interagissent pas fortement (aucune interaction forte).

2. Ils portent des charges électriques entières (multiples de la charge de l’électron).

3. Ils possèdent une charge “faible” et peuvent être regroupés en paires appelées doublets d’interaction faible.

4. Ils obéissent à la statistique de Fermi-Dirac ex. ce sont des fermions. Les trois familles ou générations de leptons connues sont:

- e νe

- μ νμ

- τ ντ

Hadrons

Les hadrons sont caractérisés par les propriétés suivantes:

1. Ce sont des particules qui interagissent fortement (soumises à l’interaction forte “résiduelle”).

2. Ils portent des charges électriques entières (multiples de la charge de l’électron).

3. Ils ont des interactions faibles.

4. Ils sont formés de quarks.

Dans les faits, les hadrons ne sont pas des particules fondamentales, mais plutôt des états liés de quarks. On en observe plus de deux cents. Les hadrons peuvent eux-mêmes être classés en deux groupes: les baryons, auxquels on associe un nombre quantique (le nombre baryonique) et les mésons qui sont responsables des interactions fortes entre hadrons. Voici les hadrons les plus fréquemment observés (baryons de spin 1/2, mésons de spin 1/2 et baryons de spin 3/2):

- p : proton

- n : neutron

- π+, π0, π- : pions

- ρ+, ρ0, ρ− : mésons ρ

- Λ : lambda

- K+, K0, ¯K0, K− : mésons K

Quarks

Les quarks sont les particules fondamentales qui forment la matière nucléaire.

1. Ils interagissent fortement (soumis à l’interaction forte)

2. Ils portent des charges électriques fractionnaires.

3. Ils possèdent une charge faible et forment des doublets d’interaction faible.

4. On leur associe aussi une charge colorée (couleur) et forment des triplets d’interaction forte.

On compte six types ou saveurs de quarks (l’existence du quark top a été confirmée en 1995): les quarks up, down, étrange, charmé, bottom (encore appelé aussi le quark beauté pour des raisons historiques) et le quark top. Comme les leptons, ils peuvent être regroupés en doublets qui sont des copies conformes sauf pour ce qui est de leurs masses.

| Q = 2/3 | Q = −1/3 |

| u(up) | d(down) |

| c(charme) | s(étrange) |

| t(top) | b(bottom) |

De façon générale, on soupçonne que les familles de quarks et leptons sont reliées; il en existe trois de chaque. Pour le moment cependant, il semble que seuls des arguments de symétrie viennent appuyer cette assertion.

Existence de trois familles

L'ensemble des particules élémentaires peut se décomposer en trois familles. Ce nombre de trois est un paramètre fondamental du modèle standard. Ces trois familles sont résumées ci-dessous.

Bosons et Fermions

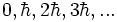

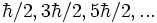

La mécanique quantique introduit la notion de moment cinétique intrinsèque d'une particule, le spin. Le spin peut prendre des valeurs qui sont des multiples de h/4π. Il détermine également le type de statistique auquel est soumise la particule.

- Bosons

Les bosons sont des particules de spin entier (

- Fermions

Les fermions sont des particules de spin demi-entier (

Particules et antiparticules

La notion d'antiparticule fut proposée par Paul Dirac en 1928. Dirac interpréta certaines solutions de l'équation qui porte son nom comme des antiparticules. Les solutions associées peuvent être interprétées comme des particules se propageant à rebours dans le temps ou encore comme des trous dans une mer de particules.

Une antiparticule se caractérise par :

- une charge et des nombres quantiques opposés à ceux de la particule associée

- une masse et une durée de vie identiques à celles de la particule correspondante

L'existence des antiparticules fut confirmée par Anderson dès 1933 par la découverte du positron (antiparticule de l'électron). Certaines particules, dont toutes les charges sont nulles, comme le photon ou le boson Z0 sont leur propre antiparticule. Par convention, l'antiparticule est désignée par une barre supérieure.

Interactions et champs

La mécanique classique et la théorie quantique des champs ont des approches différentes lorsqu'il s'agit d'écrire les interactions.

- En mécanique classique :

Un champ produit par une particule 1 à la position de la particule 2. La particule 2 interagit avec la valeur de ce champ.

- En théorie quantique des champs :

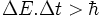

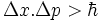

L'interaction est interprétée comme un échange de quanta. L'échange obéit aux lois de conservation des nombres quantiques et de la quadri-impulsion. La quadri-impulsion obéit à l'équation d'onde dans les limites du principe d'incertitude de Heisenberg :

Les états transitoires sont appelés virtuels, par exemple, un photon virtuel peut avoir une quadri-impulsion telle que p2 ≠ 0

Interaction électromagnétique

L' interaction électromagnétique se caractérise par les propriétés suivantes :

- met en jeu des particules chargées

- constante de couplage α =e/4π

- temps d’interaction et/ou vie moyenne typique de ∼ 10−20 s;

- section efficace typique de ∼ 10−33 m2;

- échange de photons (γ);

- mγ = 0, donc portée R = ∞.

Interaction faible

Les principales manifestations de l'interaction faible sont:

1. La désintégration β du neutron, ex. n → p + e− + ¯νe.

2. La capture d’antineutrinos, ex. p+ ¯νe → n + e+.

3. Les réactions hadroniques pures, ex. la désintégration des Σ, peuvent passer par le mode faible ou le mode électromagnétique mais les caractéristiques diffèrent suivant le mode de désintégration: int. faibles int. e.m. Σ− → n + π | {z } Σ0 → Λ + γ ΔS = 1 | ΔS{z= 0 } τ ' 10−10 s τ ' 10−19 s où ΔS est le changement du nombre quantique d’étrangeté et τ est la vie moyenne ou durée des interactions. Les interactions faibles sont alors caractérisées par les propriétés suivantes:

- met en jeu des neutrinos ou des quarks qui changent de saveur, c’est-à-dire des particules ayant une charge faible;

- couplage faible (entre protons): αFermi = GF m2 p/4π ≈ 10−6;

- temps d’interaction et/ou vie moyenne typique de ∼ 10−8 s;

- section efficace de ∼ 10−44 m2;

- échange de bosons W± (courants chargés) et Z0 (courant neutre);

- mW = 80 GeV, donc portée R = 10−18 m.

Les interactions électromagnétique et faible (électrofaibles) sont unifiées dans le modèle de Glashow-Weinberg-Salam (1967). Mais à basse énergie, la symétrie est brisée et les deux forces semblent distinctes. Les interactions faibles mettent en jeu un couplage faible gW et l’échange des bosons de jauge W± et Z0. Les réactions faibles sont caractérisées par une amplitude de probabilité de la forme :

Amplitude ∝ g2W/(q2 − M2W,Z)

où q2 est le transfert de quadri-impulsion porté dans l’échange du quantum.

Dans la limite q2 → 0, la théorie de Glashow-Weinberg-Salam se ramène à la théorie des interactions faibles de Fermi (1935) où les interactions impliquant quatre particules sont ponctuelles et de force GF , la constante de Fermi. GF ∼= 10−5 GeV−2.

Le modèle de Glashow-Weinberg-Salam a l’avantage sur la théorie de Fermi d’être renormalisable. C’est aussi un exemple d’unification de forces (faible et e.m.).

Interaction électrofaible

L'interaction électrofaible est l'interaction qui unifie l'électromagnétisme et l'interaction faible.

Interaction forte

L' interaction forte est fréquente dans les collisions de hadrons à haute énergie. Elle implique, au niveau fondamental, les interactions entre quarks et gluons. On les retrouve par exemple dans la collision K− + p → Σ0 dont la durée est d’environ τ= 10−23 s. Les interactions fortes sont caractérisées par les propriétés suivantes:

- met en jeu des particules portant une charge colorée (quarks et/ou gluons);

- couplage très fort: αs ∼ 1;

- temps d’interaction et/ou vie moyenne typique de ∼ 10−23 s;

- section efficace typique de ∼ 10−30 m2;

- échange de gluons;

- confinement des quarks et gluons;

- liberté asymptotique;

- portée effective de R = 10−15 m en raison du confinement.

Interaction gravitationnelle

Il n’existe pas actuellement une théorie de la gravité quantique satisfaisante du point de vue de la phénoménologie bien que la supercordes soit un bon candidat (la gravitation quantique à boucles cependant ne propose pas d'unifer la gravitation avec les autres interactions du modèle standard). Par contre, une théorie quantique gravitationnelle devrait posséder les caractéristiques suivantes:

- implique tout ce qui possède une énergie-masse et qui modifie la métrique (tenseur énergie- impulsion);

- couplage très faible au niveau subatomique: le couplage typique entre deux protons est αG = GNm2p /4π = 4.6 × 10−40;

- masse nulle du graviton, la gravitation ayant une portée infinie.

Tableau Récapitulatif

| particules élémentaires | fermions | leptons | électron |

| muon | |||

| tauon | |||

| neutrino électronique | |||

| neutrino muonique | |||

| neutrino taunique | |||

| quarks | quark up | ||

| quark charm | |||

| quark top | |||

| quark down | |||

| quark strange | |||

| quark bottom ou beauty | |||

| bosons | bosons de jauge | photon | |

| Z0 | |||

| W- | |||

| W+ | |||

| gluon | |||

| bosons hypotétiques | |||

| graviton | |||

| boson de Higgs | |||

| particules composées (hadrons) | baryons (fermions) | nucléons | neutron |

| proton | |||

| hypérons | lambda | ||

| sigma | |||

| ksi | |||

| omega | |||

| ... | |||

| autres baryons | delta | ||

| baryons charmés | |||

| ... | |||

| mésons (bosons) | |||

| pion | |||

| kaon | |||

| êta | |||

| rho | |||

| phi | |||

| D | |||

| J/Ψ | |||

| B | |||

| upsilon | |||

| ... |

Le modèle standard de la physique des particules

L'état actuel de la classification des particules élémentaires s'appelle le modèle standard. Il décrit les forces fondamentales fortes, faibles, et électromagnétiques en utilisant des bosons médiateurs connus sous le nom de boson de jauge. Les bosons de jauge sont le photon, les bosons W-, W+ et Z, les gluons et le graviton. Le modèle contient également 24 particules fondamentales, qui sont les constituants de la matière : les quarks et les leptons. Il prévoit aussi l'existence d'un type de boson connu sous le nom de boson de Higgs, mais qui n'a pas encore été observé.

Principales interactions avec la matière

Selon leur nature et leur énergie, les particules interagiront différemment avec la matière. Ces interactions sont les suivantes :

Particules chargées

Particules légères : électrons, positrons

- Bremsstrahlung (rayonnement de freinage), dominant au-delà de 10 MeV

- Diffusion inélastique avec les atomes (cortège électronique)

- Diffusion élastique avec les noyaux

- Rayonnement Tcherenkov

- Réactions nucléaires

Particules lourdes: muons, protons, alpha, pions

- Diffusion inélastique avec les atomes (type d'interaction dominant).

- Diffusion élastique avec les noyaux: peu d’énergie transférée, car particules plus légères que le noyau.

- Rayonnement Tcherenkov.

- Réactions nucléaires.

- Bremsstrahlung.

Particules non chargées

Photons

Contrairement aux particules chargées qui déposent leur énergie de manière continue le long de leur trajectoire, les interactions des photons sont localisées. Lorsqu'ils traversent un milieu, les photons traversent une certaine distance sans être affectés puis déposent brutalement de l'énergie par les interactions suivantes :

- Effet photoélectrique

- Diffusion Compton

- Production de paires e+ e-

- Réactions nucléaires (faible contribution)

La probabilité de produire une interaction est une fonction exponentielle de la distance parcourue. La fraction des photons qui subissent une interaction après avoir traversé une distance x est 1-e-µx où µ est le coefficient d'absorption, exprimé en cm-1, qui est la somme des coefficients d'absorption des différentes interactions. L'absorption peut être paramétrée plus généralement par le coefficient d'atténuation massique µ/rho; exprimé en cm2/g et qui est indépendant de la densité du matériau absorbant.

Neutrons

- Diffusion élastique

- Diffusion inélastique

- Capture nucléaire

- Réactions nucléaires : (n, 2n), (n,α ), (n, xn), (n,p)

- Fission nucléaire

Neutrinos

- interactions électrofaibles (création de leptons)

Détecter les particules

Les détecteurs de particules sont basés sur les phénomènes de leurs interactions avec la matière, qui ont été abordés précédemment. Les principes de quelques types des détecteurs de particules couramment utilisés aujourd’hui vont être détaillés.

Les détecteurs à ionisation

Ce type de détecteur mesure la charge déposée par une particule chargée traversant un milieu ionisable, qui peut être un gaz, un liquide, voire un solide, chacun ayant ses avantages et ses applications.

Une particule chargée suffisamment énergétique est capable d'arracher les électrons des atomes du milieu traversé, c'est le processus d'ionisation. Le nombre moyen de paires d’électrons et d'ions primaires ainsi créées par le passage d’une particule chargée est donné par la formule de Bethe-Bloch: N = -d.dE/dx / W où d est l’épaisseur du détecteur, et W l’énergie moyenne nécessaire pour créer une paire. Dans les gaz W est de l'ordre de 30 eV.

Dans un détecteur à ionisation, le milieu est plongé dans un champ électrique généré par une paire d'électrodes, généralement de géométrie cylindrique ou plane. Les électrons nouvellement créés se déplacent alors vers l'anode et les ions, vers la cathode. Selon le type d'effet voulu, l'anode peut prendre la forme d'un ou plusieurs fil très fin près duquel le champ électrique devient très intense et où les électrons sont accélérés jusqu'à être capables d'ioniser d'autres atomes, créant des électrons secondaires, capables à leur tour d'ioniser des atomes, ceci plusieurs fois de suite. C'est le phénomène d'avalanche.

Les électrons, environ mille fois plus rapides que les ions, sont rapidement capturés par l'anode, mais le courant des ions dérivant vers la cathode induit un signal électrique relativement important sur les électrodes, directement mesuré par un pré-amplificateur qui produit le signal électronique.

Le signal détecté par l’amplificateur dépend de plusieurs facteurs, et avant tout du champ électrique appliqué entre les électrodes et, dans le cas d'un détecteur à gaz, de la pression.

Les régions opérationnelles des détecteurs à ionisation sont les suivantes :

- La région de recombinaison

Lorsque le champ électrique entre les électrodes est faible, les électrons et les ions peuvent se recombiner en atomes aussitôt après leur création. Seule une petite fraction des charges d’ionisation est détectée par l’amplificateur.

- La région d’ionisation et les chambres à ionisation

Une fois que le champ électrique est assez fort pour limiter les recombinaisons, les charges d’ionisation dérivent presque intégralement vers les électrodes. On obtient un signal qui reflète la charge totale d’ionisation. Les détecteurs opérant dans cette région, par exemple les chambres à argon (Ar) liquide et les détecteurs à semi-conducteurs (Si, Ge), ont une excellente résolution en énergie et le signal mesuré est déjà assez proportionnel à la charge déposée (bonne linéarité). Les signaux sont assez faibles parce qu’il n’y pas d’amplification des charges dans le détecteur, et des amplificateurs spéciaux à bas bruit sont nécessaires.

- La région proportionnelle

Si le champ électrique est suffisamment fort (E ~ 104 V/cm), les électrons sont accélérés par le champ électrique et gagnent assez d’énergie pour produire des ionisations secondaires. Puisque la probabilité d’une ionisation secondaire par unité de longueur (a) est constante pour un champ électrique donné, le nombre total d’ionisations est proportionnel au nombre d’ionisations initiales: N = N0 eαd. Le facteur multiplication est donné par M = eαd = 104 à 108. Les détecteurs opérant dans la région proportionnelle sont généralement des détecteurs à gaz, parce que les gaz permettent d'obtenir un grand facteur de multiplication lors de l'avalanche. L’avantage des chambres proportionnelles est qu’elles n’exigent pas d’électronique à bas bruit. Elles peuvent être utilisées pour les mesures d’énergie, mais la précision est moins bonne à cause de la fluctuation du processus d’amplification et le facteur de multiplication dépend de plusieurs facteurs d’environnement (tension, température, etc.). L’application la plus importante des chambres proportionnelles est la mesure de position, comme les chambres proportionnelles multi-fils (Multi-Wire Proportional Chambers, ou MWPC) et les chambres à dérive. Les chambres à dérive sont idéales comme traceur devant un calorimètre parce que les particules perdent peu d’énergie dans les gaz. Les avantages des chambres à gaz incluent un nombre relativement faible de fils d'anode, et une bonne résolution spatiale, de l'ordre de 50 µm, et une construction facile permettant des détecteurs de grande surface.

- La région Geiger

Lorsque le champ électrique est suffisamment fort, les électrons primaires sont capables d'ioniser d’autres atomes très rapidement et une avalanche très intense se produit. De plus, un grand nombre de photons sont créés dans le processus par désexcitation des atomes. Ces photons initient eux aussi des avalanches d’ionisation par effet photo-électrique, au long du fil d’anode où le champ électrique est le plus fort. Ces avalanches sont suffisamment intenses pour générer une décharge électrique dans le gaz, si puissante qu'elle est audible. C’est le principe du compteur Geiger. La décharge ne s’interrompt que lorsque la charge d’espace formée par la gaine d’ions positifs autour de l’anode écrante suffisamment le champ électrique autour de celle-ci pour que le processus de multiplication ne puisse plus continuer. Pendant ce temps le détecteur n’est plus sensible aux ionisations primaire, ce jusqu’à ce que les ions aient migré suffisamment loin de l’anode. C’est l’origine du temps mort dans le compteur Geiger.

Dans une décharge, le courant d’anode est saturé. L’amplitude du signal est donc indépendante des charges primaires. Les compteurs Geiger ne peuvent pas mesurer l’énergie des particules, mais on les utilise pour compter le nombre de particules le traversant, même aux faibles énergies. Ceci est utile pour les mesures de radioactivité. Le taux maximal mesurable est limité par le temps mort.

- La région de décharge

Augmenter le champ au-delà de la région Geiger entraîne une décharge continue. Un détecteur n’est plus utile s’il se trouve dans cette région.

Les détecteurs à scintillation

Certains milieux transparents émettent une petite quantité de lumière en désexcitation après avoir été excités par une particule chargée (fluorescence). Ces photons peuvent être détectés par un dispositif photosensible, si le milieu est transparent dans le domaine de longueur d’onde correspondant au moins à certains de ces photons. Il existe divers milieux qui satisfont à cette condition de transparence :

- Les scintillateurs organiques (plastique, liquide, cristal)

Leur mécanisme de fluorescence est associé aux états excités des molécules. La scintillation est basée sur les électrons 2π des liaisons C-C des molécules. La lumière émise est généralement dans l'UV. Des exemples de scintillateurs organiques cristallins sont le naphtalène, l'anthracène ou le p-terphenyl. Les scintillateurs organiques plastiques ou liquide sont constitués d'un solvant et d'un soluté. Les solvants rencontrés dans les scintillateurs organiques liquides sont le plus souvent le benzène, le toluène ou le xylène; en scintillateurs plastiques on trouvera le polyvinylbenzène, le polyvinyltoluène, ou le polystyrène. Les solutés secondaires et tertiaires les plus largement utilisés pour des liquides ou des plastiques sont le p-terphenyl, le DPO, le PBD, le POPOP, le BBO, ou le BPO.

Les scintillateurs plastiques sont fabriqués par des méthodes complexes de polymérisation.

Les scintillateurs organiques ayant un faible numéro atomique moyen (ils sont composés essentiellement d'atomes de carbone et d'hydrogène), ils ont une faible efficacité de détection des photons gamma. Ils sont sensibles presque uniquement à l'effet Compton. En revanche, grâce à leur forte teneur en hydrogène, ils permettent une très bonne détection des neutrons par des réactions de type (n,p).

- Les scintillateurs inorganiques (cristal): NaI(Tl), CsF2, BGO, …

Leur mécanisme de fluorescence est associé à la présence d'états intermédiaires appaissant par la présence d'impuretés (le thallium dans l'iodure de sodium par exemple). Plusieurs constantes de temps existent dans les scintillateurs inorganiques, elles sont dues à la présence de deux types de recombinaisons : une recombinaison rapide des centres d'activation (de l'ordre de la microseconde), et une recombinaison retardée associée au piègeage des porteurs (de l'ordre de de la milliseconde). Possédant généralement un numéro atomique (Z) élevé, les scintillateurs inorganiques sont efficaces pour la détection des particules chargées mais aussi des photons. L'intensité de la luminescence des scintillateurs inorganiques dépend fortement de la température. Le germanate de Bismuth (BGO) voit sa luminescence décroître d'environ 10% entre 0° et 40°, alors que celle de l'iodure de sodium (NaI(Tl)) augmente d'environ 5% dans cette même plage de température.

Les scintillateurs sont couplés à des photodétecteurs qui transforment la lumière émise par le scintillateur en électrons qui viendront former le signal utile (courant). Ces transformateurs de lumière sont appelés photomultiplicateurs (PMT), ils produisent des électrons à partir de la lumière et jouent un rôle d'amplificateur de ces électrons, qui sont produits initialement en très faible nombre.

Le but d’un photomultiplicateur est de convertir les photons de scintillation en un signal électrique, qui peut être ensuite traité électroniquement (amplificateur etc.). Le principe physique est l’effet photo-électrique, produit avec la photocathode, qui est en général une mince couche d’un alliage métallique alcalin. On définit l’efficacité quantique (h) comme le nombre de photo-électrons créés par photon incident. Typiquement h ~ 0.25, et il est fonction de la longueur d’onde du photon.

Derrière la photocathode se trouve une série d’électrodes appelées dynodes (pouvant aller de dix à quatorze), formées d’un alliage particulier, souvent du CuBe, portées à des potentiels électriques croissants. Les photo-électrons émis par la photocathode sont accélérés et focalisés sur la première dynode, en arrachant 2 à 5 électrons par photo-électron, amplifiant ainsi le signal électrique.

Le même mécanisme d’amplification se reproduit sur chacune des dynodes successives, produisant un gain pouvant atteindre 107 après 14 étages.

L’efficacité d’un détecteur à scintillation dépend donc de plusieurs facteurs :

– sa longueur d’atténuation

– sa perte de photons (efficacité de collecte)

– son efficacité quantique.

Les détecteurs scintillateurs sont utilisés en calorimétrie, pour des mesures de temps de vol, comme détecteurs de traces, en tant que déclencheurs ainsi que pour des compteurs véto.

Les détecteurs à semiconducteur

Les détecteurs à semi-conducteurs sont un type particulier de détecteurs à ionisation. Au lieu d’exciter ou de ioniser le milieu, une particule interagissant dans un semi-conducteur crée des paires d’électron-trous. Les porteurs libres ainsi générés dans le semiconducteur vont migrer sous l'effet du champ électrique et induire un courant électrique mesurable. Il suffit de quelques électron-volts pour en créer une paire (comparé à 30 eV pour une ionisation dans un gaz). Le signal mesuré dans les semi-conducteurs est donc intrinsèquement plus important, ce qui les rend très performants.

- Avantages :

– Très bonne résolution en énergie, incomparable à basse température avec les détecteurs HPGe (Germanium de haute pureté).

– Détecteurs compacts (puisque solides).

– Précision, bonne résolution spatiale (structuration en pixels et micro-bandes, utilisation des technologies issues de la micro-électronique).

- Inconvénients :

– Chers, fragiles, susceptibles d'être dégradés par les radiations

Les principaux semi-conducteurs utilisés en détection de rayonnement ionisants sont :

- le Germanium et plus particulièrement le HPGe (High Purity Germanium), très performant en spectrométrie gamma

mais devant être utilisé à des températures cryogéniques (77K).

- le Silicium, en général avec adjonction de lithium Si(Li). Son pouvoir d'arrêt limité fait qu'il est plutôt utilisé en

basse énergie.

- l'Arséniure de Gallium.

- le Tellurure de Cadmium CdTe et le CdZnTe.

- le Iodure de Mercure HgI2.

La structure des détecteurs à semi-conducteur

Détecteurs à jonction

La structure de base d’un détecteur à semi-conducteur est une jonction inversement polarisée.

- Selon le dopage utilisé, le type de porteur majoritaire dans un semi-conducteur

peut être les électrons (type n) ou les trous (type p)

- Quand deux semi-conducteurs de types différents sont juxtaposés,

la diffusion thermique des porteurs et la recombinaison électrons-trous créent une zone sans porteurs de charge à l'interface, et forme ainsi une jonction (zone de déplétion). Une barrière de potentiel se forme dans cette zone, limitant la conduction entre les deux semi-conducteurs (cette zone est comparable à la zone de capacité d’une chambre à ionisation).

- Une paire électron-trou générée par un photon interagissant dans la zone déplétée va être séparée et générer ainsi une tension V = e / C où e est la charge élémentaire et C la capacité de jonction.

- L’application d’une polarisation inverse (Vn > Vp) élargit la zone de déplétion, ce qui augmente le volume de détection et donc l’efficacité.

Détecteurs bulk

De manière à obtenir une meilleure efficacité de détection, en particulier à haute énergie, on utilise également des structures possédant une zone non dopée (intrinsèque) volumineuse insérée entre deux contacts pouvant être des zones semiconductrices dopée (structure en diode p-i-n) ou simplement des contacts métalliques (structure métal-semiconducteur-métal, cf. jonction Schottky). En règle général, on polarise les jonctions en inverse de manière à minimiser le courant d'obscurité et donc d'optimiser le rapport signal sur bruit.

Les caractéristiques des détecteurs à semi-conducteur

- Efficacité

L'efficacité d'un détecteur semi-conducteur dépend de nombreux facteurs : le type et l'énergie du rayonnement incident, sa géométrie, la densité et le numéro atomique du matériau utilisé, les éventuelles zones mortes dues aux propriétés de transport des porteurs et au mécanisme d'induction de signal. Cependant, les détecteurs semi-conducteurs étant solides et donc relativement denses, ils sont à géométrie égale souvent plus efficaces que les détecteurs à gaz.

- Résolution en énergie

Dans les semi-conducteurs, quelques eV suffisent à créer une paire électron-trou, ce qui est environ 10 fois moins que un gaz, et 100 fois moins qu'avec un scintillateur. Cela se traduit par une meilleure résolution en énergie, puisque la statistique sur le nombre de charges élémentaires créées est plus favorable. La fluctuation du nombre de charges collectées est donc moins importante, d'où une meilleure résolution intrinsèque. Cependant, d'autre facteurs de dégradation tempèrent cette caractéristique très favorable : le bruit dû au courant de fuite, celui dû au circuit de lecture et les déficits causé par les collectes incomplètes.

- Linéarité

Les détecteurs à semi-conducteur ont une bonne linéarité, dans la mesure où seuil de perte d’énergie est très faible. Néanmoins pour les particules fortement ionisantes, comme les ions lourds, l’efficacité de collecte est affectée par l’effet de charge spatiale (les charges dérivent moins vite, donc il y a plus de recombinaison, parce que le champ électrique est diminué).

- Courant de fuite

Même si la jonction est inversement polarisée, il existe un très faible courant (~nA) à travers la jonction. Ce courant de fuite vient des mouvements des porteurs de charge, et aussi des effets des impuretés et des effets de surface.

- Temps de montée

Les détecteurs à semi-conducteurs sont très rapides. Le temps de montée du signal correspond au temps de transit des porteurs. Il peut aller de la nanoseconde à la microseconde selon la géométrie du détecteur et l'intensité du champ électrique.

Les applications des détecteurs à semi-conducteur

- Mesures d’énergie

Les détecteurs à semi-conducteur ont une excellente résolution en énergie. Cependant l'efficacité des détecteurs à jonction est limitée par l’épaisseur de la zone de déplétion (de l’ordre du mm).

- Mesures de position, en profitant des technologies de la

microélectronique pour fabriquer des motifs d'électrode précis sur le cristal :

– Détecteur au silicium de micro-bande

– Détecteur à pixel, CCD (charge coupled device)

Les détecteurs Cherenkov

Une particule chargée à vitesse v qui traverse un milieu d’indice de réfraction n polarise les atomes tout au long de son parcours, qui deviennent des dipôles électriques. Ces dipôles émettent un rayonnement électromagnétique.

Si la vitesse de particule ne dépasse pas celle de la lumière dans ce milieu, c’est-à-dire v < c/n, les rayonnements des dipôles de deux côtés du parcours s’annulent. Si v > c/n, la matière en aval ne peut être polarisée, le champ créé par la particule se propageant moins vite que celle-ci. Un rayonnement net en résulte, qui constitue l’effet Cherenkov.

La perte d’énergie par le rayonnement Cherenkov est négligeable (~1% de la perte par ionisation). Noter aussi que le rayonnement Cherenkov se produit dans tous les milieux transparents, y compris les scintillateurs. Mais la scintillation est ~100 fois plus intense.

Le seuil de rayonnement Cherenkov est beta > 1/n. Au seuil le rayonnement est émis en avant (Theta c=0). L’existence du seuil pour le rayonnement Cherenkov est exploité pour distinguer les particules chargées des masses différentes. Ce sont des compteurs Cherenkov à seuil.

Les particules chargées plus lourdes que mseuil n’émettent pas de rayonnement Cherenkov. On peut ainsi distinguer les particules chargées plus lourdes ou plus légères que mseuil dans un faisceau. Par exemple, dans un faisceau mélangé d’électrons et de pions chargés, on peut déclencher sur les électrons en mettant mseuil > mp. On utilise souvent un compteur Cherenkov à gaz, puisque l’indice de réfraction n est facilement réglé avec la pression du gaz.

Plusieurs compteurs à seuil peuvent également être enchaînés pour pouvoir distinguer plusieurs particules de même impulsion en même temps. Par exemple en combinant 3 compteurs avec n1 > n2 > n3 correctement choisis, on peut différencier les pions, les kaons et les protons.

Grandes expériences de physique des particules

En physique des particules, les collaborations internationales principales sont:

- le CERN, situé sur la frontière franco-suisse, près de Genève. Ses équipements principaux sont le LEP (Large Electron Positron, le grand collisionneur d'électrons et de positrons) maintenant démantelé et le LHC (Large Hadron Collider, le grand collisionneur d'hadron) en cours de construction.

- le DESY, situé à Hambourg, en Allemagne. Son installation principale est HERA, où l'on provoque des collisions entre des électrons ou des positrons et des protons.

- le SLAC, situé près de Palo Alto, aux États-Unis. Son installation principale est PEP-II (collisions d'électrons et de positrons).

- le Fermilab, situé près de Chicago, aux États-Unis.

Son installation principale est le Tevatron (collisions de protons et d'antiprotons).

- Le laboratoire national de Brookhaven, situé sur Long Island, aux États-Unis. Son installation principale est le Relativistic Heavy Ion Collider, où l'on étudie des collisions entre des ions lourds tels que des ions d'or et des protons.

De nombreux autres accélérateurs de particules existent.

Objections contre la physique des particules

Au sein même de la physique, il y a des objections à l'approche extrêmement réductionniste d'essayer d'expliquer tout en termes de particules élémentaires et de leurs interactions. Ces objections sont habituellement formulées par les physiciens de l'état solide. Le modèle standard lui-même n'est pas mis en cause mais ils considèrent que la vérification et le perfectionnement du modèle n'est pas aussi important que l'étude des propriétés des atomes et des molécules et particulièrement de leurs propriétés dans des ensembles statistiquement grands. Ces critiques maintiennent que même une connaissance complète des particules élémentaires ne donne pas la connaissance complète des atomes et des molécules, la connaissance qui est la plus importante d'un point de vue pratique.

Les réductionnistes proclament généralement que tout progrès en sciences a impliqué le réductionnisme dans une certaine mesure.