Erreur (métrologie) - Définition

Le calcul d'erreur, ou calcul d'incertitudes est un ensemble de techniques permettant d'estimer l'erreur faite sur un résultat numérique, à partir des incertitudes ou des erreurs faites sur les mesures qui ont conduit à ce résultat. Ceci permet donc d'estimer la propagation des erreurs.

L'erreur de mesure détermine la sensibilité (Capacité à sélectionner les bons " candidats ") et la sélectivité (capacité à éliminer les mauvais " candidats ") d'une méthode.

Cet article est lié au : |

| Portail Sciences |

| Science |

| Disciplines scientifiques |

| Méthode scientifique |

| Recherche scientifique |

| Sciences de la nature |

| Biologie, Chimie, Physique, Sciences de la Terre, ... |

| Sciences humaines |

| Anthropologie, Économique, Linguistique, Psychologie, Sociologie, ... |

| Sciences formelles |

| Algèbre, Géométrie, Informatique, Logique, Topologie, ... |

| Méta |

| Page projet |

Erreur de mesure

Il faut considérer trois sources d'erreur (uncertainty en anglais) :

- la précision de la mesure Δ1, ou l'incertitude (resolution en anglais) ;

- la dispersion statistique Δ2 (precision en anglais) ;

- l'erreur systématique Δ3 (accuracy en anglais).

l'erreur totale étant

- Δ = Δ1 + Δ2 + Δ3

Si l'on fait la comparaison avec des flèches que l'on tire sur une cible :

- la précision de mesure (resolution) désigne la taille de la pointe de la flèche ;

- la dispersion statistique (precision) désigne le fait que les flèches sont proches les unes des autres, ou bien au contraire éparpillées sur la cible ;

- l'erreur systématique (accuracy) indique si les flèches visaient bien le centre, ou bien un autre point de la cible.

Métaphore de l'incertitude de mesure : a) la dispersion statistique et l'erreur systématique sont faibles ; b) la dispersion statistique est forte mais l'erreur systématique est faible ; c) la dispersion statistique est faible mais l'erreur systématique est forte.

Précision de mesure

Sur un appareil analogique, la première limitation est la distance séparant les graduations ; on peut améliorer ceci avec un vernier, comme sur un pied à coulisse ou certains goniomètres, ou bien avec une vis micrométrique comme sur un Palmer. Sur un appareil numérique, cette précision est donnée par le nombre de chiffres de l'affichage.

- Δ1 est l'espacement entre les graduations, ou bien la valeur d'une unité du dernier chiffre de l'affichage

Mais il se peut que le phénomène soit instable ou bien perturbé par un phénomène extérieur aléatoire. Alors, on verra l'aiguille osciller ou bien les derniers chiffres de l'affichage numérique changer. Ceci réduit la précision de mesure, on ne peut considérer que la partie stable du nombre obtenu. Voir l'article Rapport signal sur bruit.

Lorsque l'on utilise des publications très anciennes pour évaluer un événement non reproductible (l'objet a disparu ou s'est altéré, ou bien il s'agit d'un événement unique), on doit parfois avoir recours à une échelle empirique, comme par exemple l'échelle de Mercalli ou de Rossi-Forel pour les séismes ou l'échelle de Mohs pour la dureté d'un matériau, l'évaluation de Δ1 devient alors difficile ; cela n'est possible que si l'on peut établir une correspondance avec une échelle " moderne " basée sur une mesure physique. Par exemple, on essaie d'établir une correspondance entre les dégâts d'un séisme décrits dans des écrits antiques et l'énergie des ondes sismiques.

De même, lorsque la mesure consiste à classifier un phénomène dans une catégorie (cas par exemple d'un sondage d'opinion ou du recensement des pathologies), il n'est pas possible de définir Δ1.

Dispersion statistique

Si l'on mesure plusieurs fois le même phénomène avec un appareil suffisamment précis, on obtiendra chaque fois un résultat différent xi. Ceci est dû à des phénomènes perturbateurs ou, pour les mesures extrêmement précises, à la nature aléatoire du phénomène (chaos, incertitude quantique).

Parmi les phénomènes perturbateurs, on peut dénombrer :

- l'erreur d'échantillonnage : c'est lorsque l'on prélève un échantillon qui n'est pas représentatif de ce que l'on veut mesurer ; le résultat dépend alors de la manière dont on choisit l'échantillon;

- l'erreur de préparation : c'est lorsque la préparation de l'échantillon introduit un biais ; l'échantillon s'altère pendant le transport, le stockage ou la manipulation (pollution, dégradation, transformation physique ou chimique) ;

- la stabilité de l'appareil : celui-ci peut être sensible aux variations de température, de tension d'alimentation électrique, aux vibrations, aux perturbations électromagnétiques des appareils environnants… ou bien présenter un défaut de conception ou une usure (bruit de fond électronique, pièce instable…)

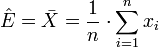

Sur un grand nombre de mesures, on peut considérer que l'on a une probabilité dont la distribution est gaussienne. Le résultat de la mesure sera alors la moyenne empirique Ê des résultats

le carré de l'écart type σ² de la gaussienne peut s'évaluer avec la variance empirique corrigée

L'erreur due à la dispersion statistique est alors estimée par

k étant une constante dépendant du niveau de confiance, c'est-à-dire de l'erreur admissible.

En physique, on prend souvent k = 3, ce qui correspond à un intervalle de confiance de 99,73 %, c'est-à-dire que 99,73 % des valeurs xi sont comprises entre Ê - Δx et Ê + Δx et 0,27 % seront hors de cet intervalle ; sur 1 000 mesures, seules trois seront en dehors de l'intervalle. Dans de nombreux cas, on se contente de prendre k = 2, soit un niveau de confiance de 95 % (5 mesures hors intervalle pour cent mesures). Pour une entreprise ayant une production énorme, 0,27 %, et a fortiori 5 %, peuvent être encore trop

- par exemple, imaginons qu'une entreprise produise des pièces dont la longueur ? doit avoir une précision Δ? donnée ; l'outil de production, après réglage, produit des pièces avec une dispersion σ sur ? ;

- si Δ? = 2·σ, alors pour un milliard de pièces produites, 50 million iront au rebut, ce qui est énorme ;

- si Δ? = 3·σ (grâce à une optimisation de l'outil de production, l'entreprise a divisé la dispersion σ par un facteur 1,5), alors pour un milliard de pièces produites, 2,7 millions iront au rebut, ce qui est encore important ;

- si elle réussit à diminuer σ encore de moitié, on aura alors Δ? = 6·σ, soit un taux de rebut de 2·10-9 (0,000 000 2 %), deux pièces iront au rebut par milliard produit. Ce niveau de confiance très exigeant a donné son nom à une méthode de gestion appelée Six Sigma.

Voir aussi les articles Critères de dispersion et Loi normale.

Si l'on a peu d'échantillons, il faut utiliser un coefficient plus grand pour prendre en compte l'erreur faite sur la détermination de Ê et de

| Niveau de confiance | 5 mesures | 10 mesures | 20 mesures | > 100 mesures (loi normale) |

|---|---|---|---|---|

| 50 % | 0,73·σ | 0,70·σ | 0,69·σ | 0,67·σ |

| 68 % | 1·σ | |||

| 70 % | 1,16·σ | 1,09·σ | 1,06·σ | 1,04·σ |

| 87 % | 1,5·σ | |||

| 90 % | 2,02·σ | 1,81·σ | 1,73·σ | 1,65·σ |

| 95 % | 2,57·σ | 2,23·σ | 2,09·σ | 1,96·σ |

| 99 % | 4,03·σ | 3,17·σ | 2,85·σ | 2,56·σ |

| 99,7 % | 3·σ | |||

| 99,9 % | 6,87·σ | 4,59·σ | 3,85·σ | 3,28·σ |

| 99,999 999 8 % | 6·σ |

Note : les valeurs sont arrondies

Sur une gaussienne, la largeur à mi-hauteur (full width at half maximum, FWHM) représente un intervalle de confiance d'environ 76 % (soit 3/4) pour un grand nombre de mesures.

Dans le cas de mesures physiques ou chimiques, l'évaluation de la dispersion statistique se fait par des mesures de répétabilité et de reproductibilité, et éventuellement par des mesures croisées inter-laboratoires :

- répétabilité : un même opérateur effectue plusieurs fois la même mesure, et l'on relève les résultats ; ceci permet d'évaluer la stabilité dans le temps de l'appareil et de l'échantillon (vieillissement dans l'appareil ou hors de l'appareil) ; dans le cas d'une analyse chimique, on mesure plusieurs fois le même échantillon ;

- reproductibilité : on mesure plusieurs fois le même matériau ou phénomène ; la différence avec la répétabilité est que l'on reprépare à chaque fois la mesure (par exemple prélèvement de l'échantillon et conditionnement pour la mesure, ou bien mise en place de l'appareil de mesure et réglage préalable) et que ceci est fait par différentes personnes ; ceci permet de prendre en compte la totalité de la chaîne de mesure et les erreurs humaines ;

- essais croisés interlaboratoires, ou essais circulaires : un échantillon inconnu est envoyé à plusieurs laboratoires et l'on compare les résultats, on prend ainsi en compte la diversité des appareils de mesure et les habitudes de travail.

Si la précision de mesure est inférieure à la dispersion statistique, on mesure alors toujours le même résultat (aux erreurs de lecture ou d'utilisation près), cf. infra.

- Note

- Dans le cas d'un phénomène aléatoire (processus stochastique, cas par exemple du sondage d'opinion), on ne cherche pas à connaître une valeur et une erreur, mais à connaître la répartition statistique des valeurs. Voir aussi Loi des grands nombres.

Erreur systématique

L'erreur systématique comprend des phénomènes comme l'erreur d'échantillonnage, l'erreur de préparation ; ces problèmes peuvent introduire une dispersion statistique (cf. ci-dessus) ou bien un décalage des résultats si l'erreur commise est toujours la même.

Les appareils dérivent avec le temps, ce qui rend nécessaire leur ré-étalonnage régulier. On peut avoir une très faible dispersion statistique, et avoir toutefois un résultat faux...

On peut aussi tout simplement... mesurer un paramètre qui ne représente pas de manière pertinente ce que l'on veut évaluer. Par exemple, en économie, le produit intérieur brut par habitant est un mauvais estimateur du développement d'un peuple. Dans un sondage d'opinion, la question peut orienter la réponse.

Propagation de l'erreur

Le résultat d'une mesure est fréquemment utilisé pour faire des calculs. Par exemple, dans le cas d'un radar routier (cinémomètre) on mesure un décalage de fréquence et ce décalage est utilisé pour calculer la vitesse du véhicule, avec la loi de Doppler-Fizeau. Il faut donc, à partir de l'erreur commise sur la mesure du décalage de fréquence, estimer l'erreur sur la vitesse.

D'une manière générale, on mesure une valeur x, et l'on calcule une valeur y = ƒ(x) ; on veut estimer Δy à partir de Δx.

Erreur et test d'acceptation

La mesure sert fréquemment dans les tests d'acceptation, c'est-à-dire que la valeur mesurée détermine si l'objet répond bien aux critères imposés. Cette notion est assez large :

- en médecine, cela permet de poser un diagnostic (éliminer ou confirmer une maladie) ;

- dans la fabrication, cela permet de dire si le lot de matière première peut être utilisée, ou si le produit fabriqué est conforme au cahier des charges ;

- en docimologie, cela permet de délivrer un diplôme, une certification ;

- pour un appareil de mesure : à déterminer si

- la méthode convient à l'usage (peut-on utiliser telle méthode pour mesurer tel paramètre dans telles conditions avec telle précision ?) ;

- le modèle d'appareil convient à l'usage (choix d'un fournisseur, choix dans la gamme d'un fournisseur) ;

- l'appareil livré et installé correspond aux spécifications ;

- le manipulateur, le laboratoire utilise une procédure fiable (préparation, manipulation…).

On estime en général qu'une méthode ne peut être utilisée que si la dispersion statistique est au moins 5 ou 10 fois inférieure à la valeur limite.

- Par exemple, si pour un métier on n'accepte que les personne mesurant au moins 1,60 m, il faut une méthode de mesure ayant une dispersion statistique inférieure à 16 cm.

- Par exemple, si la teneur en soufre dans une essence doit être inférieure à 150 ppm en masse, il faut une méthode de mesure ayant une dispersion statistique inférieure à 15 ppm.

De manière générale, la fourchette de valeurs d'admissibilité doit prendre en compte l'erreur globale. Le sens de la prise en compte de l'erreur globale dépend du type de risque que l'on veut éviter :

- si l'on veut éviter les faux positifs (c'est-à-dire accepter un produit alors qu'il est inacceptable), on resserre la fourchette ;

- si l'on veut éviter les faux négatifs (c'est-à-dire rejeter un produit valable), alors on élargit la fourchette.

Pour tester un appareil ou une procédure, on vérifie que les tests de répétabilité et de reproductibilité sont compatibles avec la précision visée ; pour tester une méthode de mesure, on vérifie que les essais interlaboratoires (ou circulaires) sont compatibles avec la précision visée (cf. supra).